2025年12月19日上午,美国印第安纳大学伯明顿分校卢迪信息学、计算与工程学院的Susan C. Herring教授应我中心邀请在线举行学术讲座,分享其团队利用生成式人工智能展开质性语篇分析的前沿成果。Herring教授是数字语篇研究领域具有开创性影响的著名学者。早在20世纪90年代,她率先将语言学与计算机媒介交流研究相结合,系统提出并发展了计算机媒介语篇分析(Computer Mediated Discourse Analysis, CMDA)的理论框架与分析方法,为理解数字沟通中的语言形式、互动结构与社会意义奠定了基础。她的研究贯穿早期电子邮件、在线论坛到当代社交媒体的人际互动、图像化交流与人工智能等多种数字语境,对数字语篇研究、网络语言学及新媒体语篇研究产生了深远而持续的影响。本次讲座吸引了来自美国、英国、澳大利亚、新加坡、马来西亚、香港及国内三十多所高校400余名师生的参与。

讲座由广东外语外贸大学张艺琼教授主持。张教授在开场致辞中简要回顾了Herring教授在计算机媒介语篇研究中的开创性贡献,并指出,作为数字语篇研究的先行者,Herring教授近期密切关注人工智能语篇,既将其视为新的语篇研究对象,也将其作为分析工具加以反思性审视。

讲座伊始,Herring教授从自身的学术训练与研究背景出发,回顾了CMDA方法论体系的形成与发展。她指出,CMDA立足于对在线语言使用的系统观察,强调对语篇形式、功能与社会语境之间关系的精细分析。然而,传统质性语篇分析高度依赖研究者对小规模语料的人工细读,尽管能够揭示语言使用中的复杂性与微妙差异,却难以在研究规模和效率上回应当下数字语料爆炸式增长的现实需求。

在此基础上,Herring教授提出了本次讲座的两个核心问题:大语言模型(LLM)是否具备进行质性语篇分析的能力?如果具备,人类研究者应如何系统化地使用这种能力?她以自己与博士生团队近期完成的一项研究为例,详细介绍了围绕上述问题所展开的探索路径。

首先,在分析对象的选择上,研究团队从CMDA框架中选取了三类具有代表性的语用现象:计算机媒介交流行为(CMC acts)、元行为(meta-acts)以及礼貌策略(politeness)。Herring 教授指出,这三类现象均建立在成熟的理论传统之上,同时又高度依赖研究者的解释性判断,因而非常适合作为检验生成式人工智能质性分析能力的切入点。

其次,在语料选择方面,研究使用了两个风格差异显著的Reddit公共讨论帖作为数据来源:其一为主题直接、情绪表达外显的“青少年监狱经历”讨论帖,其二则为社会张力隐含、语用策略更为微妙的“游戏社交冲突”讨论帖。通过对比不同语篇风格下大语言模型的分析表现,研究得以考察生成式人工智能在处理显性与隐性语用意义时的差异。

在研究流程上,团队首先对语料进行了多轮人工质性分析与编码,并通过反复讨论达成研究者之间的一致结果,作为后续比较的基准。在此基础上,研究者为付费版的ChatGPT-4.0、Claude Sonnet和Gemini 2.5三种主流大语言模型设计并反复迭代提示词,引导大语言模型对同一语料进行自动化分析。随后,团队构建了系统的内容分析编码手册,对模型输出与人工编码结果进行对照,量化评估其准确率与一致性水平,并进一步对人机分歧进行类型化分析。

在介绍提示词设计时,Herring教授进行了较为系统的讲解。她指出,团队所使用的提示词通常包括以下关键要素:为大语言模型设定明确的分析角色、提供总体分析指令、列出特殊约束条件、规定逐步的标注流程、限定输出格式、提供示例输出、设定质量标准,并要求大语言模型逐步陈述其推理过程。她同时分享了团队使用的提示词最新版本(见文末链接),并强调提示词并非一次性完成,而是在研究过程中与编码体系同步不断调整和优化的结果。这一过程不仅有助于人类分析者厘清复杂语用现象的分析原则(如意愿类行为的界定、非真实言语行为的识别、转述视角的层级区分以及礼貌判断的高度语境依赖性),也使人工智能能够更好地实践人类分析者在质性分析中所体现的“分析智慧”。

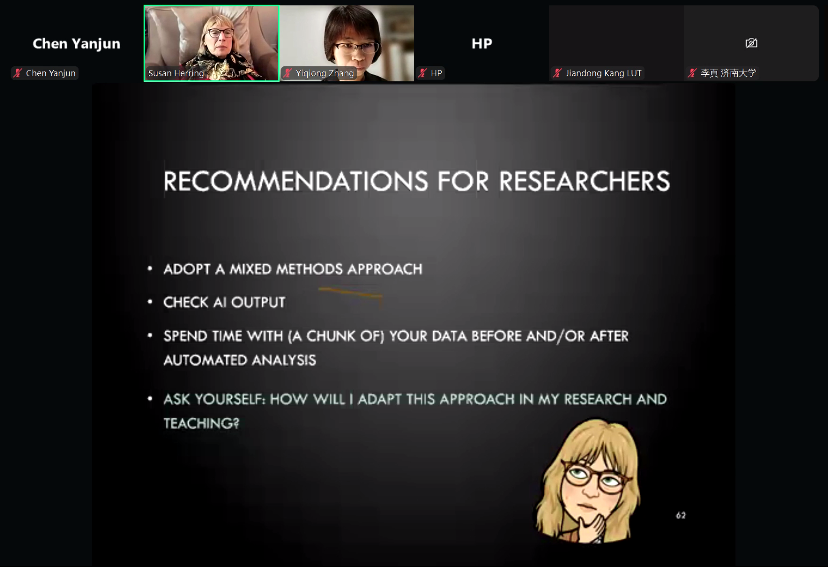

在研究结果部分,Herring教授报告了大语言模型表现的整体评估情况。结果显示,大语言模型在CMC行为识别方面的表现整体优于礼貌策略和元行为分析,不同模型以及不同语料条件下的表现差异显著。其中,Gemini在意愿类行为和复杂礼貌策略的分析中总体表现最佳。尽管在严格意义上的一致率仍然有限,但进一步的分歧性质分析表明,绝大多数模型判断要么与人类编码一致,要么被研究者视为“可接受的偏差”,甚至在个别案例中优于人类的初始判断。Herring教授建议采用人机结合的混合方法研究设计,既利用人工智能加深自己对语料的理解,也警惕人工智能分析中的幻觉。

在随后的提问与讨论环节,与会听众围绕生成式人工智能参与质性语篇分析的准确性标准、方法论意义及学术规范等问题展开了热烈而深入的交流。针对“准确性”如何界定的问题,Herring 教授指出,本研究中的准确性并非绝对意义上的“正确”,而是与高质量人工编码结果之间的一致程度。鉴于质性语篇分析包含解读元素,人类判断亦并非终极标准,生成式人工智能在某些情况下反而有助于揭示分析框架中的模糊地带与理论边界。

针对不同大型语言模型表现差异及模型快速迭代的问题,Herring教授强调,相关研究的价值不在于追逐最新模型版本,而在于记录特定时间点技术能力的真实表现,为后续比较研究提供可追溯的参照。她同时指出,模型性能高度依赖具体任务类型,不存在放之四海而皆准的“最优模型”,但通过精细化的提示词设计以及概念定义与示例的补充,可以显著提升模型在特定分析任务中的稳定性与一致性。

在谈及非英语语料的处理时,Herring教授指出,在涉及复杂语用意义与文化内涵的研究中,仍应尽可能基于语料的原始语言开展分析,并结合多种大语言模型进行对比。但同时,她也提到,随着模型迭代速度的加快,翻译技术不断进步,译文与原文之间的距离正在逐步缩小,不少分析软件已经逐步放弃提供多语言服务,这会带来何种影响有待探究。她进一步指出,生成式人工智能存在文化与意识形态的偏向,可通过在提示词中补充背景信息来减弱影响,也可以将其视为一个有价值的研究课题,而非单纯的技术缺陷。

最后,针对研究流程透明度、单人编码情形下的信度保障以及生成式人工智能在教学中的应用前景等问题,Herring 教授强调,无论是否引入人工智能,质性语篇研究都应严格遵循基本的方法论规范。对新手研究者,她建议可通过同伴互评来提升编码信度,或在样本规模较大时采用抽样检验。在教学层面,生成式人工智能适合作为引导学生理解编码决策复杂性、促进其反思分析合理性的辅助工具,而不应被用作提供“标准答案”的替代方案。

讲座引发了观众的热烈提问。尽管预留了半个小时用于问答环节,仍未能回应完所有问题,考虑到已经是Herring教授当地时间晚上十一点,讲座不得不结束。结束前,张艺琼教授对 Herring 教授毫无保留、深入细致的分享表示诚挚感谢,并指出,此次报告不仅呈现了前沿研究成果,更向在场听众生动展示了一位学术大家如何以踏实、严谨的态度推进学术研究的深度。

本次讲座系统展示了生成式人工智能在质性语篇分析的潜力与局限,为数字语篇研究在人机协作框架下的发展提供了重要启示。

备注:考虑到版权问题,本次讲座ppt和prompt文件不公开。请关注Susan C. Herring教授的网页https://homes.luddy.indiana.edu/herring/ ,相关论文一旦发表,Herring教授会在她个人网页上提供论文及所有相关文件的链接。